更新记录

1.0.20200429(2020-04-30) 下载此版本

首次提交

平台兼容性

| Android | Android CPU类型 | iOS |

|---|---|---|

| √ | armeabi-v7a:未测试,arm64-v8a:未测试,x86:未测试 | × |

原生插件通用使用流程:

- 购买插件,选择该插件绑定的项目。

- 在HBuilderX里找到项目,在manifest的app原生插件配置中勾选模块,如需要填写参数则参考插件作者的文档添加。

- 根据插件作者的提供的文档开发代码,在代码中引用插件,调用插件功能。

- 打包自定义基座,选择插件,得到自定义基座,然后运行时选择自定义基座,进行log输出测试。

- 开发完毕后正式云打包

付费原生插件目前不支持离线打包。

Android 离线打包原生插件另见文档 https://nativesupport.dcloud.net.cn/NativePlugin/offline_package/android

iOS 离线打包原生插件另见文档 https://nativesupport.dcloud.net.cn/NativePlugin/offline_package/ios

注意事项:使用HBuilderX2.7.14以下版本,如果同一插件且同一appid下购买并绑定了多个包名,提交云打包界面提示包名绑定不一致时,需要在HBuilderX项目中manifest.json->“App原生插件配置”->”云端插件“列表中删除该插件重新选择

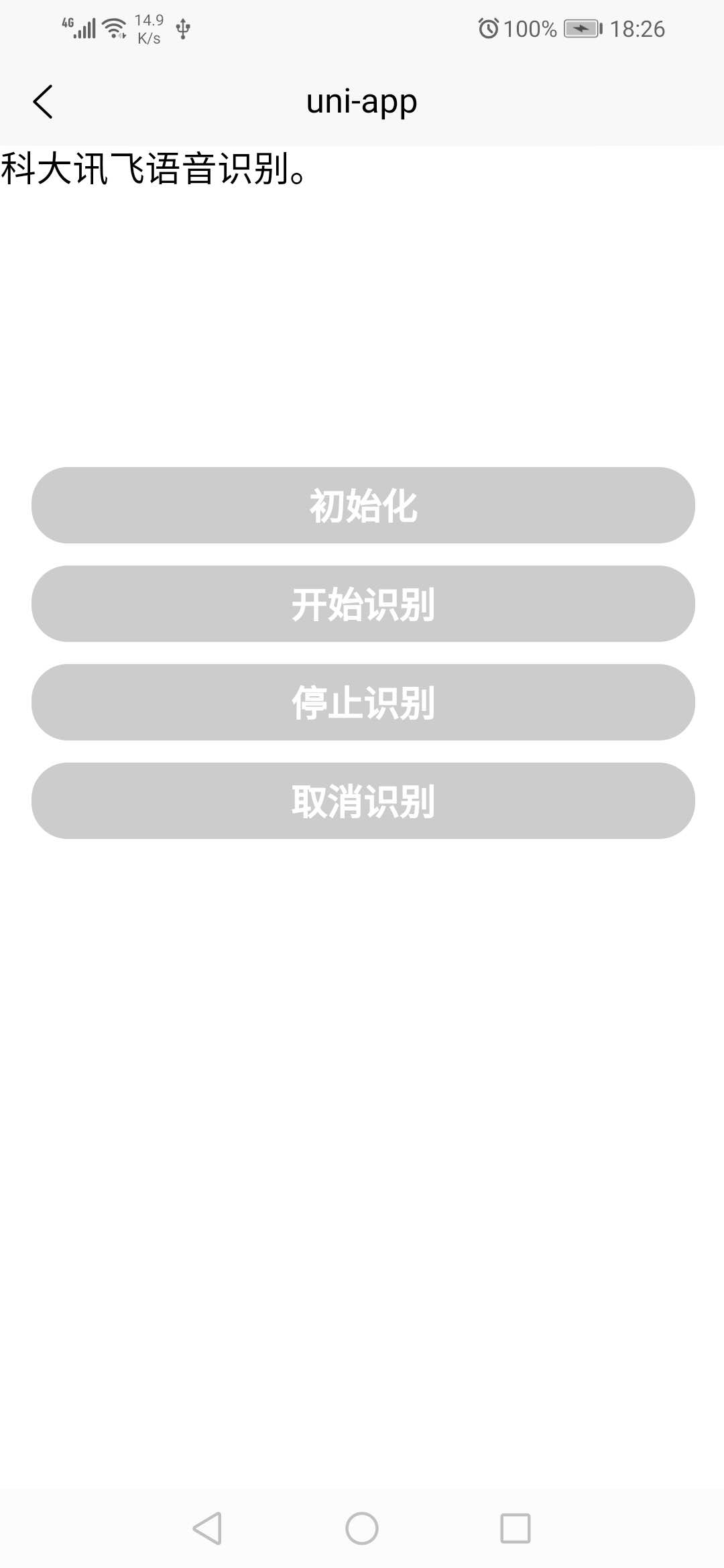

使用说明: 本插件将科大讯飞的语音听写SDK进行了集成,主要是为了关掉默认的识别界面,官方的实在太丑了,而且uniapp还不支持关闭, 没办法只能自己搞了。 目前只支持安卓,功能很简单,目前只有以下几个接口: (使用时一定要先申请录音权限哦,官方hello-uniapp的例子里有个demo,请参考里面的写法)

1、在需要的页面上获取插件 const lyzmlVoice = uni.requireNativePlugin("lyzml-VOICE");

2、根据appId初始化插件,appid需要去科大讯飞官网进行申请 lyzmlVoice.initIFly({ appId:"" },(res)=>{ console.log("===initIFly===",res); });

3、开始语音听写,参数详见科大讯飞官网

lyzmlVoice.startRecognize({

"language":"zh_cn",

"accent":"mandarin",

"vadBos":"4000", //开始录入音频后,音频后面部分最长静音时长,取值范围[0,10000ms],默认值4000ms

"vadEos":"1000", //开始录入音频后,音频后面部分最长静音时长,取值范围[0,10000ms],默认值1000ms。

"asrPtt":"1", //仅中文支持)标点符号添加1:开启(默认值)0:关闭

"asrDwa":"wpgs" //动态修正功能,必须先在科大讯飞官网开通

},(res)=>{

console.log("===startRecognize===",res);

if(1 == res.code){

this.voiceVal = res.result;

//返回结果code:0开始录音,1返回识别结果,2结束录音

}

});

4、停止识别,可以不用,停止说话后会自动停止,详见说明3 lyzmlVoice.stopRecognize((res)=>{ console.log("===stopRecognize===",res); });

5、取消识别,可以不用 lyzmlVoice.cancelRecognize((res)=>{ console.log("===cancelRecognize===",res); });

收藏人数:

收藏人数:

购买(

购买( 下载 for 离线打包

下载 for 离线打包

赞赏(1)

赞赏(1)

下载 1798

下载 1798

赞赏 1

赞赏 1

下载 12787

下载 12787

赞赏 1

赞赏 1

赞赏

赞赏

京公网安备:11010802035340号

京公网安备:11010802035340号